초지능 AI 스타트업 트릴리온랩스는 대규모 언어모델(LLM)의 추론성능을 소규모 프록시 모델로 예측할 수 있는 새로운 방법론 ‘알브릿지(rBridge)’를 21일 발표했다.

대규모 언어모델(LLM)을 학습하려면 막대한 연산 비용이 든다. 특히 추론 능력은 모델이 일정 규모에 도달하기 전까지는 거의 드러나지 않다가, 임계점을 넘는 순간 복잡한 수학 문제나 다단계 논리 문제까지 풀어내는 등 급격히 나타나는 특성을 보인다.

이러한 특성 때문에 작은 모델만으로는 대형 모델의 추론 성능을 예측하기가 어려워, 불가피하게 막대한 비용을 들여 대규모 학습을 반복해야 했다.

트릴리온랩스가 개발한 알브릿지는 이러한 기존의 한계를 극복하도록 작은 모델(프록시 모델, 10억 개 이하 매개변수)만을 가지고도 대형 모델(최대 320억 개 매개변수)이 실제로 얼마나 뛰어난 추론 능력을 보여줄지 효과적으로 예측할 수 있도록 설계됐다.

언어모델은 원래 ‘다음 단어를 예측하는 방식’으로 학습된다. 하지만 기존에는 이 학습 방식을 고려하지 않고 다른 기준으로 성능을 평가해 작은 모델의 결과가 큰 모델의 성능을 제대로 보여주지 못했다. 알브릿지는 평가 방식을 학습 목표와 실제 과제에 맞추어 작은 모델이 대형 모델의 성능을 더 정확히 대신할 수 있도록 했으며, 이를 통해 큰 모델을 직접 학습하지 않고도 성능을 미리 가늠할 수 있게 했다.

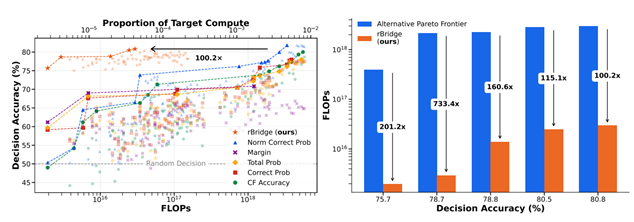

이 방법을 통해 알브릿지는 데이터셋 평가와 순위 매기기에 드는 비용을 기존보다 100배 이상 줄였다. 대규모 모델을 직접 학습하지 않아도 작은 모델만으로 데이터셋의 품질을 빠르고 저렴하게 확인할 수 있어, 새로운 데이터셋 실험이나 산업별 특화 모델 개발에서 연구자와 기업 모두 큰 비용 절감 효과를 얻을 수 있게 됐다.

트릴리온랩스의 알브릿지 기술은 혁신적인 연산 효율성을 입증하며, 기존 방법 대비 최대 733배 높은 효율성을 기록했다. 동일한 예측 정확도를 내는 데 필요한 연산량도 기존보다 훨씬 적었다.

이번 기술은 1억 파라미터보다 더 작은 모델부터 최대 320억 파라미터 규모의 다양한 모델을 대상으로 검증됐으며, 총 6개의 핵심 추론 벤치마크를 통해 성능이 확인됐다.

이 벤치마크에는 초등·중등 수준의 수학 단어 문제 해결(GSM8K), 고등 수학 수준 문제 해결(MATH), 과학·상식 기반 추론(ARC-C), 대학·전문가 수준 지식 평가(MMLU Pro), 프로그래밍 및 코드 생성 정확도 평가(HumanEval) 등이 포함됐다.

알브릿지는 이 모든 까다로운 과제 전반에서 압도적인 효율성을 보여주며, 대규모 언어모델 개발의 비용 절감과 속도 향상에 크게 기여할 것으로 기대된다.

신재민 트릴리온랩스 대표는 “이번 연구 성과는 작은 모델로도 대형 모델의 추론 능력을 신뢰성 있게 예측할 수 있다는 가능성을 처음으로 입증한 것”이라며 “연구자들이 데이터셋과 모델 설계를 훨씬 더 효율적으로 선택할 수 있는 길을 열었다는 점에서 LLM 연구와 AI 생태계의 새로운 전환점이 될 것”이라고 말했다.

강홍민 기자 khm@hankyung.com

관련뉴스