“어린 공룡 렉스는 커다란 은색 원반이 스쿨버스 옆으로 떨어지자 놀라지 않을 수 없었어요.”

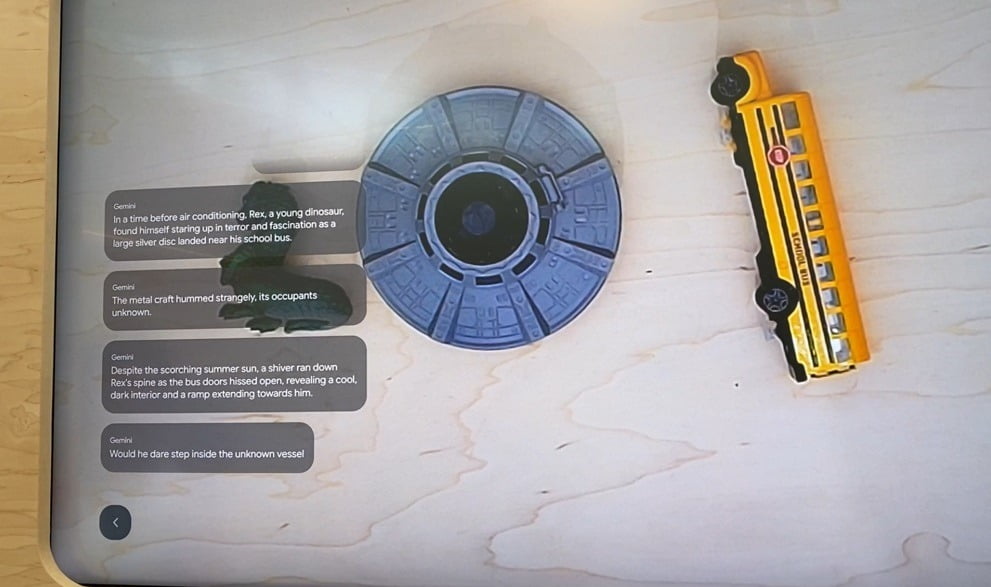

15일(현지시간) 구글 연례 개발자 회의(I/O)에서 처음 공개한 ‘프로젝트 아스트라’ 체험부스에서 인공지능(AI)이 창작 동화를 들려줬다. 프로젝트 아스트라는 구글의 최신 AI 모델인 제미나이를 기반으로 개발한 멀티모달 AI 어시스턴트다. 사람처럼 보고 듣고 말하면서 사용자를 도와준다. AI에 공룡 장난감, 원형 우주선, 스쿨버스 3개의 장난감을 보여주고 “이들을 주인공으로 동화 이야기를 들려달라”고 말했다. 그러자 AI는 망설임 없이 이야기를 시작했다.

행사 이틀째인 이날 참가자들은 캘리포니아 마운틴뷰 본사 옆에 있는 쇼어라인 엠피씨어터의 체험부스에서 구글의 다양한 AI 모델을 직접 체험했다. 특히 프로젝트 아스트라 부스에선 긴 줄이 늘어섰다. 부스는 벽에 대형스크린과 천장에서 아래 테이블을 비추는 카메라로 구성됐다. 사용자는 스크린에 텍스트나 그림을 그리거나 실시간 영상으로 대화할 수 있었다. 기자가 화면에 보라색으로 고양이를 그리자, “예쁜 고양이를 그렸구나. 잘했어”라고 말했다. 고양이가 웃는 표정도 알아봤고, 발을 추가로 그리자 “고양이에게 손이 생겼어”라고 반응했다. 카메라에 말없이 휴대전화를 올려놓아 봤다. AI는 “스타일리시한 스마트폰이구나”라고 말했다. 다만, 어떤 브랜드의 무슨 모델인지에 대해서는 파악하지 못했다.

프로젝트 아스트라는 이전 영상에 대한 기억력도 있었다. 동물 인형 3개를 순차적으로 보여준 뒤 “첫 번째로 보여준 인형이 뭐였지”라고 묻자 “강아지”라고 답했다. 실제 동물이 아닌 인형이라는 점도 구별했다. 반응 속도가 인간 수준으로 빠른 건 아니었지만 자연스러운 대화가 가능한 수준이었다. 구글이 작년 말에 내놓은 차세대 대규모언어모델(LLM) 제미나이의 멀티모달 성능이 상당한 수준으로 올라왔음을 짐작할 수 있었다.

하지만 이미지 인식 과정에서 오류가 발생하고, 사용자의 말을 제대로 못 알아듣거나, 동문서답하는 경우도 있었다. 언어도 영어만 알아들었다. 전날 시연영상에선 휴대전화를 사용했지만, 이날은 고정된 스크린과 카메라로 활용해 생생한 현실감을 느끼기엔 부족했다.

구글은 프로젝트 아스트라는 기술적 완성도를 높인 뒤 올해 하반기에 출시할 예정이다. 시각과 청각 등 일부 기능부터 단계적으로 내놓을 방침이다.

프로젝트 아스트라는 오픈AI가 지난 13일 깜짝 발표한 ‘GPT-4o’와 비슷했다. 비교를 위해 GPT-4o도 직접 사용해봤다. 가장 큰 차이점은 GPT-4o의 경우 한국어를 인식한다는 것이다. ‘지우개와 연필로 동화를 만들어달라’고 하자 ‘연필의 실수를 감싸주는 지우개’라는 주제로 이야기 한 편을 만들었다. 다만, 지금은 챗GPT 유료 사용자만 이용해볼 수 있으며 이미지 인식 기능은 아직 열리지 않았다. 오픈AI는 몇 주내에 무료로 이 기능을 배포할 예정이다. 이 때문에 업계에선 구글이 오픈AI에 비해 기술 개발 속도가 다소 느린 것 아니냐는 평가가 나온다.

마운틴뷰=최진석 특파원 iskra@hankyung.com

관련뉴스