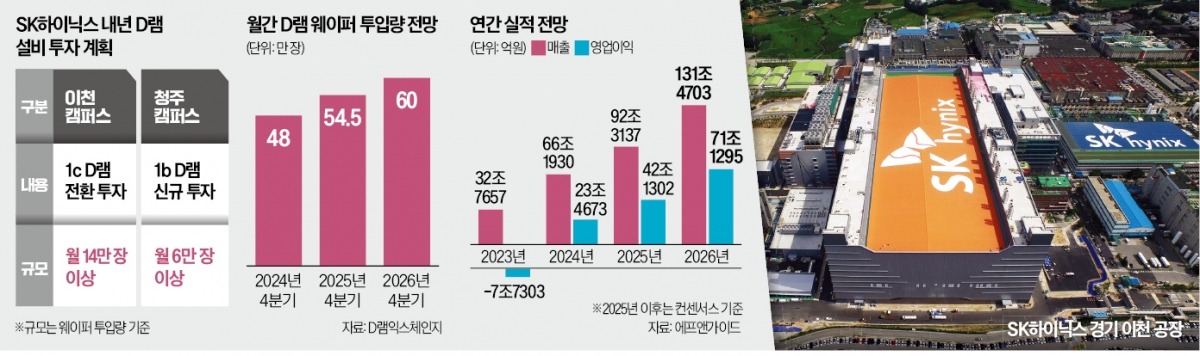

20일 반도체업계에 따르면 SK하이닉스는 내년 경기 이천캠퍼스에서 공정 전환을 통해 1c D램 생산능력을 300㎜(약 12인치) 웨이퍼 기준 월 14만 장 추가하기로 했다. 업계 관계자는 “월 14만 장은 최소 증가분”이라며 “SK하이닉스가 월 16만~17만 장 늘리는 방안도 검토하는 것으로 알고 있다”고 말했다.

SK하이닉스는 일단 연말까지 월 2만 장 안팎의 1c D램 생산능력을 갖출 예정이다. 내년부터 공정 전환에 속도를 내 연말까지 14만~17만 장을 1c D램 생산에 추가로 배정할 계획이다. 이렇게 되면 SK하이닉스의 1c D램 생산능력은 올해 말 2만 장에서 내년 16만~19만 장으로 확대된다. 현재 SK하이닉스의 월평균 D램 웨이퍼 투입량이 50만 장 안팎인 걸 감안하면 전체 D램 생산능력의 32% 이상을 최첨단 1c D램에 할애하는 셈이다.

내년 엔비디아에 본격 납품하는 6세대 고대역폭메모리(HBM4)에 들어가는 10㎚ 5세대 D램(1b D램) 증설도 동시에 한다. 올해 말 충북 청주캠퍼스에 문을 여는 신공장 ‘M15X’에 월평균 웨이퍼 6만 장이 투입되는 1b D램 라인을 들인다. 업계에서는 SK하이닉스의 공격적인 D램 투자 속도를 감안할 때 올해 25조원 수준으로 예상되는 시설투자액이 내년에는 30조원을 훌쩍 넘길 것으로 전망하고 있다.

이랬던 SK하이닉스가 범용 D램으로 눈을 돌린 건 AI 메모리산업의 판도가 달라지고 있다는 판단에서다. 학습에 집중됐던 AI 모델이 추론 영역으로 넓어지면서 HBM만큼이나 범용 D램 수요가 늘어날 것으로 본 것이다. AI 추론에는 HBM에 비해 전력 효율이 높고 가격은 저렴한 최첨단 범용 D램이 주로 쓰인다.

엔비디아가 최근 내놓은 AI 가속기 ‘루빈 CPX’가 그런 제품이다. 이 AI 가속기에는 프로세서 바로 옆에 HBM이 아니라 GDDR이 들어간다. 구글, 오픈AI, 아마존웹서비스(AWS) 등 자체 AI 칩을 개발하는 빅테크도 범용 D램을 대거 장착하는 맞춤형 AI 가속기를 개발하고 있다.

1c D램은 엔비디아에 납품하는 메모리 모듈 SOCAMM2에도 들어간다. SOCAMM은 엔비디아가 주도하는 AI 서버 및 PC용 메모리 모듈 표준으로, HBM 대비 대역폭은 낮지만 전력 효율이 높다는 장점이 있다. 엔비디아는 자체 개발한 중앙처리장치(CPU) ‘베라’ 옆에 SOCAMM2를 배치할 계획이다. 업계에선 계획대로 되면 SK하이닉스가 이 물량의 일정 수준을 따낼 것으로 예상하고 있다.

강해령/박의명 기자 hr.kang@hankyung.com

관련뉴스