지난 주요뉴스 한국경제TV에서 선정한 지난 주요뉴스 뉴스썸 한국경제TV 웹사이트에서 접속자들이 많이 본 뉴스 한국경제TV 기사만 onoff

-

대만 날아간 젠슨 황 '다급한 SOS'…'1450조 만찬'의 비밀 [강경주의 테크X] 2026-02-04 08:00:18

수 있는 모델 파라미터와 컨텍스트(AI가 한 번에 머릿속에 담고 생각할 수 있는 텍스트·이미지·토큰의 양) 길이를 크게 확장하는 방향이다. 현재 AI 성능의 한계는 연산보다 메모리 용량과 이동 비용에서 먼저 드러난다. 파인만은 이 병목을 하드웨어 레벨에서 풀어 GPU 간 NVLink 등 통신에 대한 의존을 줄이고 더 많은...

- 뉴스 > 산업

- 바로가기

-

텔레픽스 "항공우주 검색 모델 픽시, AI 성능평가 세계 2위" 2026-02-03 10:59:53

평가에서도 파라미터 규모 대비 우수한 검색 정확도를 선보였다고 밝혔다. 권다롱새 텔레픽스 데이터사이언스 부문장은 "이번에 공개한 픽시1.0은 프리뷰 단계에서 제시한 방향성을 유지하되, 항공우주 도메인 검색 성능을 보다 안정적으로 고도화하는 데 집중해 성능 평가에서 우수한 성적을 냈다"며 "픽시와 스텔라가...

- 뉴스 > 경제

- 바로가기

-

UNIST, 로봇팔 떨림 제어기술 개발 2026-02-02 16:57:21

보완했다. 환경 변화가 감지되면 제어 파라미터를 실시간으로 업데이트해 흔들림을 줄이고 목표 궤적을 유지하는 방식이다. 이번 기술은 로봇 하드웨어를 변경하지 않고 소프트웨어 업데이트만으로 적용할 수 있다는 점도 강점이다. 강 교수는 “작업 조건이 수시로 바뀌는 스마트팩토리 환경은 물론, 사람의 미세한 힘 변...

- 뉴스 > 생활문화

- 바로가기

-

AI 로봇 병사가 인지 능력을 높이려면…KAIST 해냈다 [이해성의 퀀텀 솔러스] 2026-01-27 13:45:23

수많은 파라미터를 조정한다. 이번 연구가 국방기술진흥연구소 주관 핵심기술연구개발사업의 지원을 받았다는 사실이 주목된다. 군에서 운용할 AI 드론 등을 비롯해 전투용 로봇, 무인 전차, 무인 자주포, 무인 잠수함 등 다양한 피지컬AI의 학습 속도와 운용 성능을 높일 수 있는 원천기술이란 뜻이다. 연구팀은 탭플래시...

- 뉴스 > 산업

- 바로가기

-

[AI돋보기] 채팅 넘어 '수행'으로…AI 비서가 승부 가른다 2026-01-24 06:33:00

등 빅테크들이 거대언어모델(LLM)의 파라미터(매개변수)를 늘리며 "누가 더 똑똑한가"를 놓고 '덩치 경쟁'을 벌였다면 올해는 판이 완전히 바뀌었다. 올해는 사용자의 의도를 읽고 실질적인 업무를 완결하는 'AI 에이전트(Agent·비서)'가 기술 경쟁의 최전선으로 떠올랐기 때문이다. 올해 글로벌 AI...

- 뉴스 > 경제

- 바로가기

-

[토요칼럼] 딥시크의 혁신 비결은 결핍 2026-01-23 17:13:33

단순한 질문에도 파라미터(매개변수) 수천억 개를 전부 가동하는 낭비를 저지른다. 딥시크는 자주 쓰는 지식을 값비싼 GPU가 아니라 흔한 일반 시스템 메모리(D램)에 저장해 활용하는 법을 찾았다. ‘매니폴드 제한 하이퍼커넥션(mHC)’도 고민의 산물이다. AI 모델은 연산 블록을 높이 쌓으면 똑똑해진다. 하지만 정보...

- 뉴스 > 경제

- 바로가기

-

[테크스냅] HPE, DB생명 소버린 AI 인프라 구축 2026-01-22 10:06:51

미만의 저전력으로 200억∼1천억(20B~100B) 파라미터 규모의 대형언어모델(LLM)을 구동하는 차세대 반도체 로드맵을 공개, 생성형 AI가 서버를 떠나 배터리 기반 기기에서도 일상적으로 작동할 수 있음을 선보였다. ▲ 오케스트로 그룹이 데이터 주권 확보와 AI 인프라 통제가 가능한 '소버린 AI 클라우드 데이터센터...

- 뉴스 > 경제

- 바로가기

-

모티프 이어 트릴리온랩스도 독자AI 패자부활전 도전한다(종합2보) 2026-01-20 16:03:56

지난해 9월 700억개(70B) 파라미터 규모의 LLM '트리(Tri)-70B'를 개발했다고 이 관계자는 소개했다. 트릴리온랩스는 지난해 7월 1차 공모 당시에는 의료 AI 기업 루닛이 주관한 컨소시엄으로 참여했으나 예비 심사에서 탈락했다. 모티프테크놀로지스와 트릴리온랩스가 패자부활전 참가를 공식화한 가운데 다른 AI...

- 뉴스 > 경제

- 바로가기

-

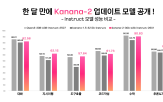

카카오, 업데이트 ‘Kanana-2’ 모델 4종 오픈소스 추가 공개 2026-01-20 09:52:14

파라미터는 32B(320억 개) 규모로 거대 모델의 높은 지능을 유지하면서도, 실제 추론 시에는 상황에 맞는 3B(30억 개)의 파라미터만 활성화해 연산 효율을 획기적으로 높였다. 이러한 아키텍처 및 데이터의 고도화 뿐 아니라 데이터 학습 단계도 고도화했다. 카카오는 이러한 기술을 바탕으로 기본(Base) 모델부터, 지시...

- 뉴스 > 산업

- 바로가기

-

독파모 첫 '재도전' 나왔다…모티프테크놀로지스 "추가공모 참여" 2026-01-20 09:44:32

'그룹별 차등 어텐션(GDA)' 기술을 자체적으로 개발해 적용했다. 12.7B 파라미터의 비교적 작은 LLM임에도 '아티피셜 애널리시스'의 인텔리전스지수(AAII)에서 모델 사이즈가 675B에 달하는 'Mistral Large 3' 같은 대형 LLM보다 높은 점수를 기록하기도 했다. 탈락한 컨소시엄 중 네이버클라우드...

- 뉴스 >

- 바로가기